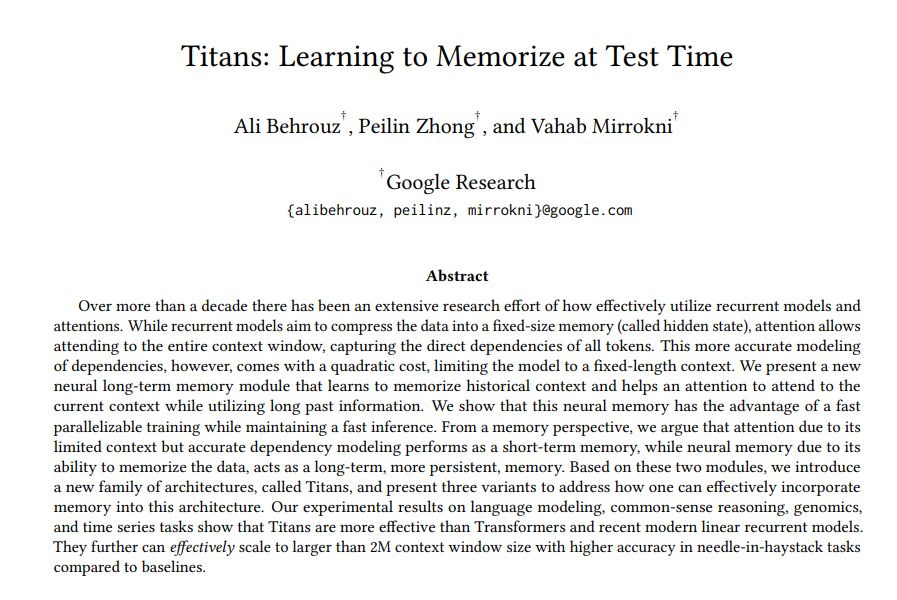

这个看了。有点启发:

人是有记忆的,而记忆是压缩的。压缩了还可以再压缩。神经网络就那么大,但是事件,信息,知识可以不断的往里存,就是因为压缩了还可以再压缩。而且这个过程并不是那种费很大劲的过程,更像是一种“浸染”的过程。

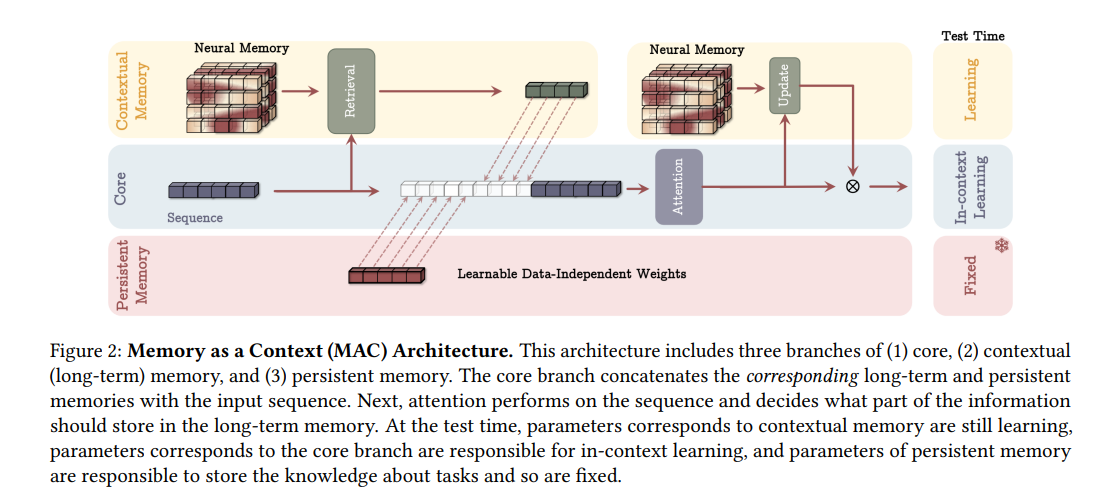

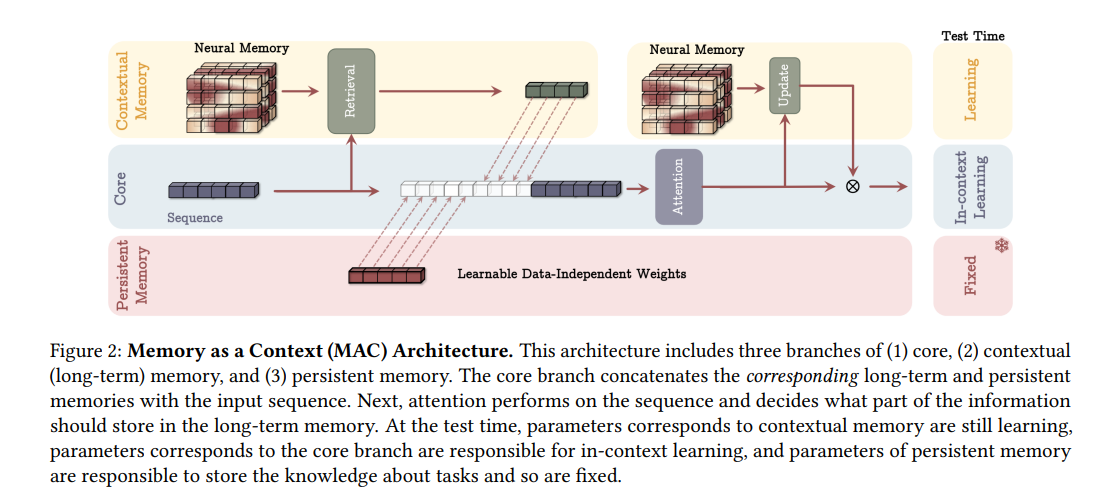

所以一个记忆体,可以体积不大,但是里面存了很长时间的事件,信息,知识。安排的合理的话,都是有用的知识。input来了,先到这个记忆体里面query一下,增广一下original input,再一起送入transformer,这就相当于增加了context length,而且相当于增加到无穷长。