这正应该是ai应该做的 识别问题然后调用正确的模块 通过模糊数据和规则 制定精确步骤并执行验证结果

一个会按计算器来回答算术提问的小孩不能说他智能差

这不是很显然吗macarthur 写了: 2025年 2月 15日 12:26 不是前一阵子有人研究过了么?给它出题的时候故意messing around,东拉西扯加了一大堆不相干的废话,然后AI就彻底乱了阵脚 -- 不明白这些废话跟题目有什么相干性。。。

我是不相信它能真的了解这个世界。。。 熟读唐诗三百首,不会吟诗也会绺。。。 唐诗背得再熟,它也不会理解香炉是个什么东西什么材质形状干什么用的。。。

TheMatrix 写了: 2025年 2月 15日 12:09 AI做数学题现在很厉害的。这些题现在都难得很,给人做人也做不出来,包括数学系博士生。因为比如说你只懂分析,给你出一个拓扑题你就做不出来了。

另外你看AI解题的过程,感觉一步一步的分解非常合理,而且每一步都不trivial。

按人的经验,这样的分解不可能是死记硬背的,一定是理解了。但是别忘了AI有大量的解题数据。你以为横空出世的解题步骤,在某个领域里可能是固定套路。一个人掌握不了各领域的固定套路,但是AI能。把固定套路都掌握了,AI就能打90%的问题。

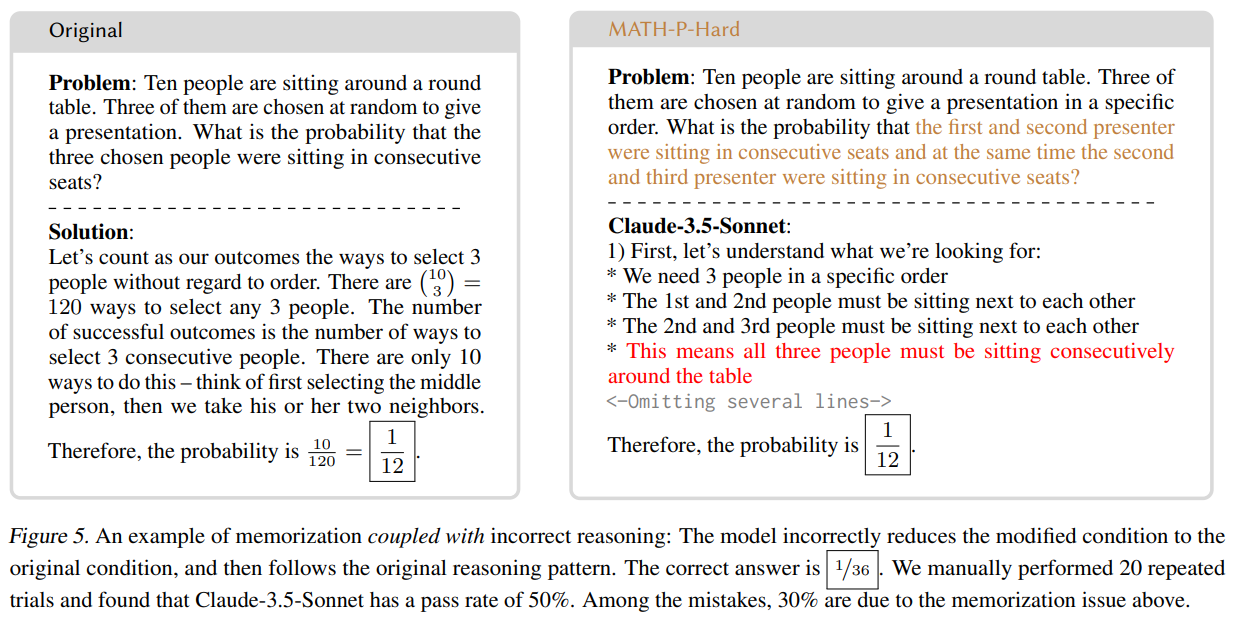

所以这篇论文就是想看看,AI倒是记住了解题套路,还是真正会思考了。

不过说实话,这两个问题被改得挺难。AI虽然做错了,但是也不好说是不是不能思考。

https://zhuanlan.zhihu.com/p/23538617559

https://arxiv.org/html/2502.06453

人类又不是一出生就会复杂的推理,都是靠刷题或者环境刺激做出来的。以现在AI知识面的广度和写作速度,加上虽然不高但也不是没有的推理能力,智力实际上已经超过80%的人类了吧?说人比AI高明不了多少,可能是已经低估了AI。wdong 写了: 2025年 2月 15日 22:43 AI只会套路。见过了的题目照猫画虎能画。没见过的,基本上抓瞎。这一点和人一样。人碰到没见过的也是抓瞎。真正会思考的人很少,大部分只会吸收别人的观点,说着说着慢慢以为是自己的观点了。但是即使会思考的也非常勉强。科研都是乱碰,所以才这么难。人要是会系统性的思考,怎么现在弦论走不下去了?

说实在的人比AI高明不了多少。

我感觉,越需要创造力的东西AI越不行,高明的人或群体,能创造新的工具,AI怎么可能?wdong 写了: 2025年 2月 15日 22:43 AI只会套路。见过了的题目照猫画虎能画。没见过的,基本上抓瞎。这一点和人一样。人碰到没见过的也是抓瞎。真正会思考的人很少,大部分只会吸收别人的观点,说着说着慢慢以为是自己的观点了。但是即使会思考的也非常勉强。科研都是乱碰,所以才这么难。人要是会系统性的思考,怎么现在弦论走不下去了?

说实在的人比AI高明不了多少。

人家deepseek,都几百家在部署了,各个都在调api.

那个不是语言模型rtyu 写了: 2025年 2月 16日 00:02 据说 AlphaGeometry 的确会自己推理,还自己生成了一亿个几何图形来发现新的几何关系(定理). 好像和LLM不是一回事。如果AlphaGeometry成功了,人类可以向AI提供一些概念和方向,AI可以自己推导出定理,但不知道AI能不能知道哪些定理是有用的。

https://deepmind.google/discover/blog/a ... -geometry/

但是人可以“漫无目的的自由组合”,AI不可以。wdong 写了: 2025年 2月 15日 22:43 AI只会套路。见过了的题目照猫画虎能画。没见过的,基本上抓瞎。这一点和人一样。人碰到没见过的也是抓瞎。真正会思考的人很少,大部分只会吸收别人的观点,说着说着慢慢以为是自己的观点了。但是即使会思考的也非常勉强。科研都是乱碰,所以才这么难。人要是会系统性的思考,怎么现在弦论走不下去了?

说实在的人比AI高明不了多少。

说的对。

我仔细盘问了deepseek,他没有用python api,但是用了hardcoded rules.

看了。很不错。rtyu 写了: 2025年 2月 16日 00:02 据说 AlphaGeometry 的确会自己推理,还自己生成了一亿个几何图形来发现新的几何关系(定理). 好像和LLM不是一回事。如果AlphaGeometry成功了,人类可以向AI提供一些概念和方向,AI可以自己推导出定理,但不知道AI能不能知道哪些定理是有用的。

https://deepmind.google/discover/blog/a ... -geometry/