分页: 2 / 2

#21 Re: AI的下一步,应该是去掉back propagation

发表于 : 2024年 12月 31日 18:41

由 wass

bp就是学习,反推:delta y —> delta x

想象不出来有更好的

#22 Re: AI的下一步,应该是去掉back propagation

发表于 : 2025年 1月 1日 10:58

由 TheMatrix

#23 Re: AI的下一步,应该是去掉back propagation

发表于 : 2025年 1月 1日 11:00

由 TheMatrix

eflame99 写了: 2024年 12月 31日 17:54

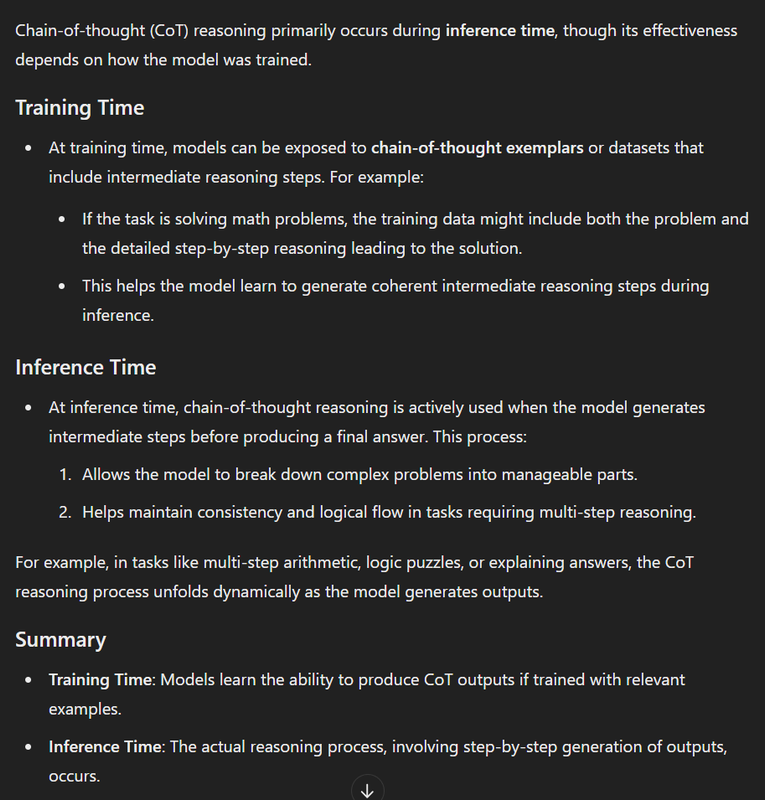

人类的学习发生在多个不同层面,在低层的神经网络有类似于back propagation的机制,例如反复使用可以促使邻近的神经元连接增强。最近大模型也涌现了一些类似于人类高级学习的能力比如in context learning 和 chain of thought,这些都不需要back propagation。

另外back propagation不能和gradient descent混为一谈。back propagation 是由neural network topology决定的,也可以很快。你说的局限主要是gradient descent。生物神经系统显然不使用gradient descent。

#24 Re: AI的下一步,应该是去掉back propagation

发表于 : 2025年 1月 1日 11:33

由 wass

bp就是一种direct feedback,可能是indirect feedback

人类的学习应该也是indirect的

#25 Re: AI的下一步,应该是去掉back propagation

发表于 : 2025年 1月 1日 17:35

由 eflame99

Chain of thought发生在inference time当然不会involve back propagation,和这个model怎么trained没有任何关系。你应该是个外行。

#26 Re: AI的下一步,应该是去掉back propagation

发表于 : 2025年 1月 1日 17:44

由 TheMatrix

eflame99 写了: 2025年 1月 1日 17:35

Chain of thought发生在inference time当然不会involve back propagation,和这个model怎么trained没有任何关系。你应该是个外行。

我指的应该叫chain of thought training:

#27 Re: AI的下一步,应该是去掉back propagation

发表于 : 2025年 1月 1日 18:04

由 island

我的理解,

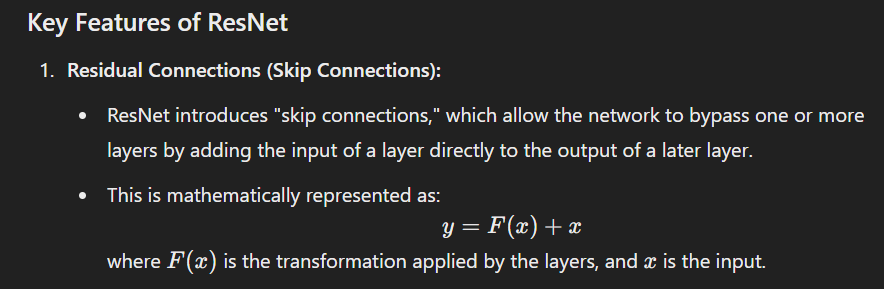

现在的神经网络只能从端到端训练,我们不知道某个中间层的正确结果应该是什么。ResNet之类只是多了快捷连接,但本质上还是端到端的。

你说的thought,其实是个理论模型,类似于某个中间层的理论结果。如果有了这个信息,训练确实可以加速。

TheMatrix 写了: 2025年 1月 1日 17:44

我指的应该叫chain of thought training:

#28 Re: AI的下一步,应该是去掉back propagation

发表于 : 2025年 1月 3日 10:05

由 wdong

我同意楼主在标题中表达的观点。但是我不同意帖子内容的观点。feedback和back propagation还是一样的。我觉得下一步是进化算法。

#29 Re: AI的下一步,应该是去掉back propagation

发表于 : 2025年 1月 3日 13:21

由 TheMatrix

wdong 写了: 2025年 1月 3日 10:05

我同意楼主在标题中表达的观点。但是我不同意帖子内容的观点。feedback和back propagation还是一样的。我觉得下一步是进化算法。

“进化算法”是具体指evolutionary algorithm,还是泛指要改进算法?

#30 Re: AI的下一步,应该是去掉back propagation

发表于 : 2025年 1月 3日 13:28

由 TheMatrix

wdong 写了: 2025年 1月 3日 10:05

我同意楼主在标题中表达的观点。但是我不同意帖子内容的观点。feedback和back propagation还是一样的。我觉得下一步是进化算法。

关于世界模型,你有没有什么想法?

#31 Re: AI的下一步,应该是去掉back propagation

发表于 : 2025年 1月 3日 14:43

由 (ヅ)

TheMatrix 写了: 2024年 12月 29日 15:09

feedback到底应该是啥,现在我也不知道。

你不知道就瞎乱说

BP当然是负反馈

一般反馈回路修正状态/输出,NN里面的状态就是模型的各个参数,稍微有点不同

当然你也可以用其他办法做负反馈

问题在于,有其他更好的吗?

也许以后都是1 bit模型会用上其他的反馈修正参数

#32 Re: AI的下一步,应该是去掉back propagation

发表于 : 2025年 1月 3日 16:52

由 wdong

TheMatrix 写了: 2025年 1月 3日 13:28

关于世界模型,你有没有什么想法?

世界模型的定义目前有点混乱。我喜欢的定义是,世界模型是agent模型的对偶。agent的输出作为世界模型的输入,产生的reward反馈给agent。具体怎么做我没有看法。

#33 Re: AI的下一步,应该是去掉back propagation

发表于 : 2025年 1月 4日 14:04

由 TheMatrix

wdong 写了: 2025年 1月 3日 10:05

我同意楼主在标题中表达的观点。但是我不同意帖子内容的观点。feedback和back propagation还是一样的。我觉得下一步是进化算法。

寻找更高效的神经网络架构,这点我想大家想法是一样的。

feedback大概的形状是,直接连根线回到比较远的前层。相当于直接在现有神经网络架构上动手脚。改动的结果肯定是大的,速度肯定是快的。但是效果好不好要试探。

Evolutionary Algorithms,系统化的寻找架构改进方案。想法是好的。但也是不知道怎么走,另外,一个神经网络就已经很大开销了,如果population of 神经网络,可能开销不起。

#34 Re: AI的下一步,应该是去掉back propagation

发表于 : 2025年 1月 5日 08:57

由 wdong

直接连根线不就是resnet吗?

TheMatrix 写了: 2025年 1月 4日 14:04

寻找更高效的神经网络架构,这点我想大家想法是一样的。

feedback大概的形状是,直接连根线回到比较远的前层。相当于直接在现有神经网络架构上动手脚。改动的结果肯定是大的,速度肯定是快的。但是效果好不好要试探。

Evolutionary Algorithms,系统化的寻找架构改进方案。想法是好的。但也是不知道怎么走,另外,一个神经网络就已经很大开销了,如果population of 神经网络,可能开销不起。

#35 Re: AI的下一步,应该是去掉back propagation

发表于 : 2025年 1月 5日 09:28

由 TheMatrix

wdong 写了: 2025年 1月 5日 08:57

直接连根线不就是resnet吗?

resnet还是有back propagation。而且它好像不是feedback,是feed forward:

我也不知道怎么才能去掉back propagation,还能更有效。

#36 Re: AI的下一步,应该是去掉back propagation

发表于 : 2025年 1月 5日 10:18

由 wdong

理解你的意思了。就是往回的feed forward。

#37 Re: AI的下一步,应该是去掉back propagation

发表于 : 2025年 1月 5日 10:22

由 TheMatrix

wdong 写了: 2025年 1月 5日 10:18

理解你的意思了。就是往回的feed forward。

对。说的很对。