Deepseek-R1在我的普通台式机跑起来了

版主: Jack12345

#1 Deepseek-R1在我的普通台式机跑起来了

Ollama,用了400G的SSD做Memory cache.机器本身是4080 super, 16G的 vram, 96G的ram.

目前已经在跑。让它讲个故事,快半个小时了才think了一段。

目前已经在跑。让它讲个故事,快半个小时了才think了一段。

x3

x1

x1

x1

x1

#4 Re: Deepseek-R1在我的普通台式机跑起来了

#4 Re: Deepseek-R1在我的普通台式机跑起来了

有tutorial么来一个

我角落里还有个7年前的1080台式机在吃灰

我角落里还有个7年前的1080台式机在吃灰

windy 写了: 2025年 2月 14日 23:53 Ollama,用了400G的SSD做Memory cache.机器本身是4080 super, 16G的 vram, 96G的ram.

目前已经在跑。让它讲个故事,快半个小时了才think了一段。

#5 Re: Deepseek-R1在我的普通台式机跑起来了

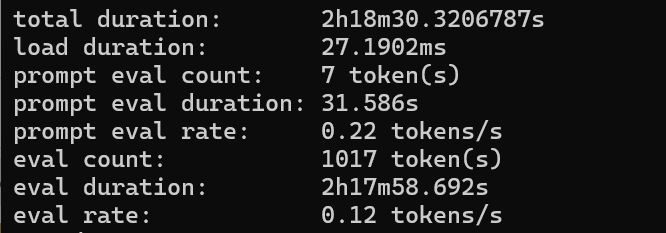

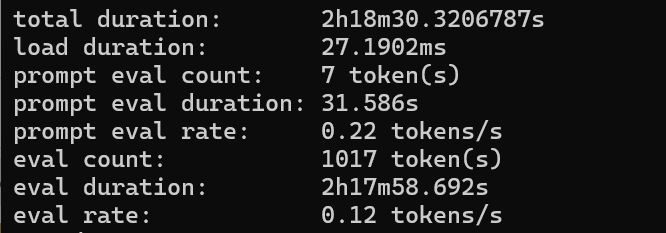

睡了一觉起来故事终于讲完了。两个半小时讲了一个小故事。0.12 token/sec.平均8秒一个单词。

这个也就是玩一下。我要经常这样跑的话,恐怕我的SSD一个月就完蛋了。

其实跑起来非常简单。到ollama.com去下一个ollama装上

打开命令行,输入ollama pull <model>

可以到ollama.com上去看有啥model 可下。比如 deepseek-r1 14b, 就用 deepseek-r1:14b.如果不选size, 这个模型又有多个size,ollama会根据你的硬件自动选一个合适的。

pull 完了用

ollama run <model> 就能跑了。如果想看有多快,加个 --verbose的选项。

对 deepseek-r1 671 b 这种内存都装不下的,要到系统设置里改一下page size.我是改成了400G,加上本来的内存和显存,显示484GB。我看了一下, 用内存最多的时候用到了416GB.

这个也就是玩一下。我要经常这样跑的话,恐怕我的SSD一个月就完蛋了。

其实跑起来非常简单。到ollama.com去下一个ollama装上

打开命令行,输入ollama pull <model>

可以到ollama.com上去看有啥model 可下。比如 deepseek-r1 14b, 就用 deepseek-r1:14b.如果不选size, 这个模型又有多个size,ollama会根据你的硬件自动选一个合适的。

pull 完了用

ollama run <model> 就能跑了。如果想看有多快,加个 --verbose的选项。

对 deepseek-r1 671 b 这种内存都装不下的,要到系统设置里改一下page size.我是改成了400G,加上本来的内存和显存,显示484GB。我看了一下, 用内存最多的时候用到了416GB.

#6 Re: Deepseek-R1在我的普通台式机跑起来了

ssd太垃圾了吧,俺的4x 990 raid0,13900k,集显,1T swap, 3 tokens per secondwindy 写了: 2025年 2月 14日 23:53 Ollama,用了400G的SSD做Memory cache.机器本身是4080 super, 16G的 vram, 96G的ram.

目前已经在跑。让它讲个故事,快半个小时了才think了一段。

上次由 anesthetic 在 2025年 2月 15日 16:43 修改。

#8 Re: Deepseek-R1在我的普通台式机跑起来了

我是4根RAID5. 只用了400 swap. 速度还可以了,读15000/s,写10000/s.我下次试试1T swap.

也许是我用显卡反而慢。我下次把显卡关掉单用CPU试试。

也许是我用显卡反而慢。我下次把显卡关掉单用CPU试试。

#10 Re: Deepseek-R1在我的普通台式机跑起来了

671的。32B的能到2-3 token/s, 14b的能有60tokens/s. Mistral-small 22b 能有45 tokens/s

x1

#11 Re: Deepseek-R1在我的普通台式机跑起来了

你是怎么做到的?用Ollama吗?

我刚试了一下70b的,完全没用到SSD (我的内存是96G),也只能做到1.34 token.你的SSD再快也不可能比我的内存快吧。我的CPU是9700X.

我刚试了一下70b的,完全没用到SSD (我的内存是96G),也只能做到1.34 token.你的SSD再快也不可能比我的内存快吧。我的CPU是9700X.

#13 Re: Deepseek-R1在我的普通台式机跑起来了

4xraid0 相当于ddr4 2666,不过你的最大问题是9700x。。。cpu inferences都是intel optimized。windy 写了: 2025年 2月 16日 19:32 你是怎么做到的?用Ollama吗?

我刚试了一下70b的,完全没用到SSD (我的内存是96G),也只能做到1.34 token.你的SSD再快也不可能比我的内存快吧。我的CPU是9700X.

#14 Re: Deepseek-R1在我的普通台式机跑起来了

你在4080 super上跑671b那个吗?那肯定慢啊

For larger models, a distributed GPU setup (e.g., NVIDIA A100 or H100 in multi-GPU configurations) is recommended due to significant VRAM requirements.

4080 super也就用来跑一下14b的

For larger models, a distributed GPU setup (e.g., NVIDIA A100 or H100 in multi-GPU configurations) is recommended due to significant VRAM requirements.

4080 super也就用来跑一下14b的