分页: 6 / 8

#91 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 19:29

由 da1gaku

xiaoju 写了: 2023年 12月 19日 19:06

貌似ChatGPT的API里没有还没有准确率这个选项吧,比如如何设定不知道就说不知道,千万不要胡说,内容的准确性非常重要请尽一切可能交叉校对这个需求

其实语言模型的evaluation一直是难点,包括以前早期模型。

如果有参照文本,那些传统metrics比如BLEU, ROUGE还是可以用,但会低估模型的水平。现在也有专门针对大模型的评估办法,有各种利弊。

有些特定任务,比如从文本里抓取一些entity,评估比较简单

#92 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 19:42

由 minren

Caravel 写了: 2023年 12月 19日 18:20

只要有百分之一的错误率就不能serious用,和自动驾驶一样

只有差个广告,写个新闻摘要非关键性任务可以用

非也。

有个 4 岁的孩子 Alex 因慢性疼痛,在 3 年时间内共看了17个医生,竟然17个专业人士都无法找到疼痛的原因。直到有了 ChatGPT,孩子母亲将其病情症状描述给ChatGPT,立刻得到正确的诊断结果。这个例子也反映了它会在许多方面有过人的的长处。

#93 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 19:54

由 hhcare

minren 写了: 2023年 12月 19日 19:42

非也。

有个 4 岁的孩子 Alex 因慢性疼痛,在 3 年时间内共看了17个医生,竟然17个专业人士都无法找到疼痛的原因。直到有了 ChatGPT,孩子母亲将其病情症状描述给ChatGPT,立刻得到正确的诊断结果。这个例子也反映了它会在许多方面有过人的的长处。

牛逼, 你信就好。

#94 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 20:32

由 Havana

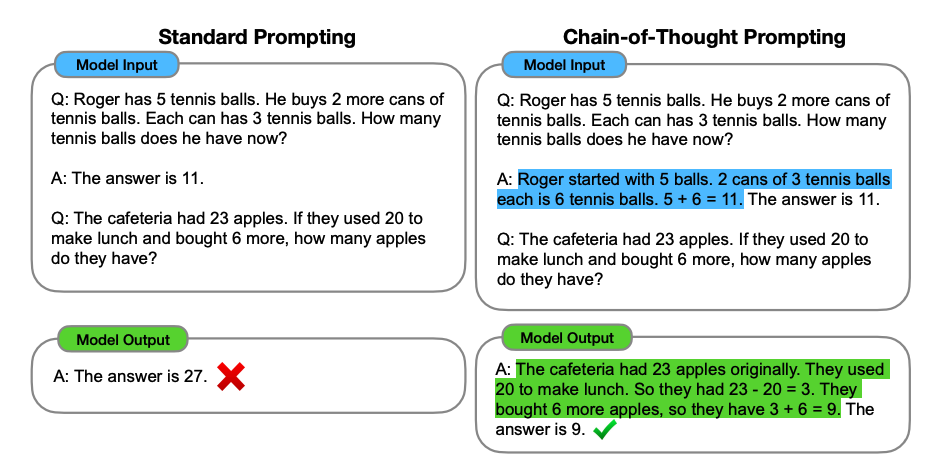

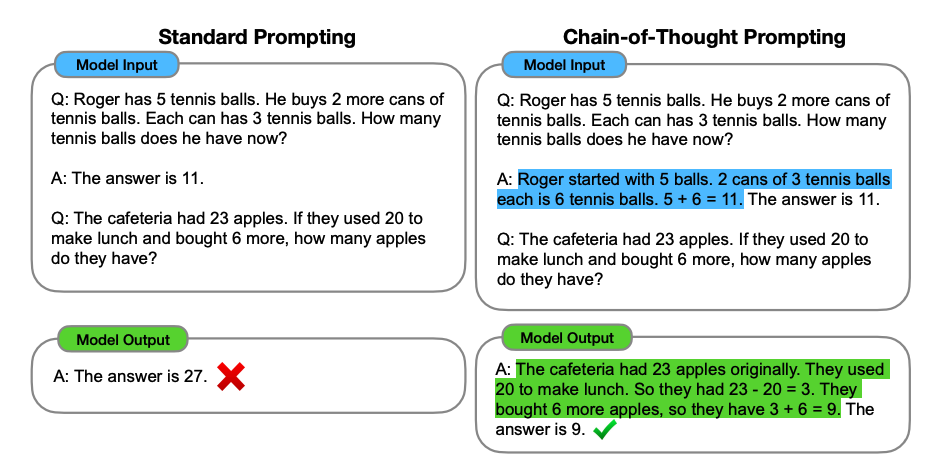

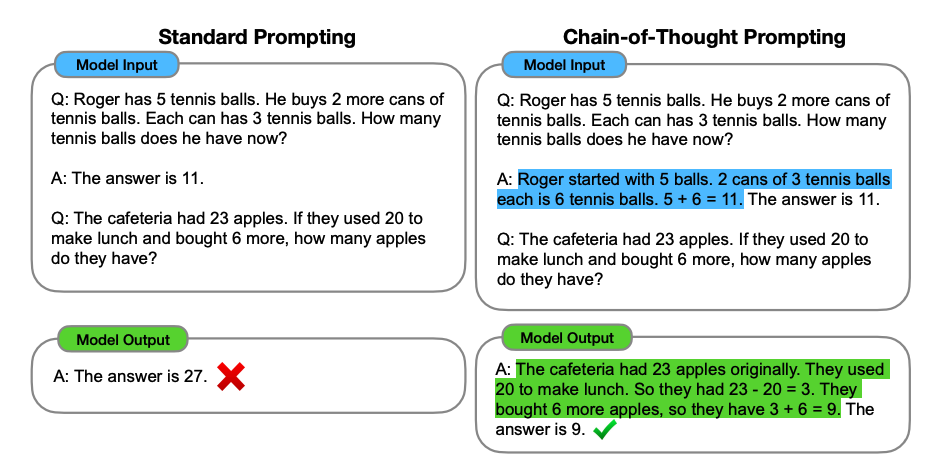

chatgpt促成了prompt engineering就说明它是个笑话

da1gaku 写了: 2023年 12月 19日 18:30

可能你的prompt可以改进一下。

比如举例说哪些不能改,然后再试。

我们现在都要develop prompt,不可能一次就能用

#95 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 20:33

由 saibaster

Caravel 写了: 2023年 12月 19日 14:14

大语言模型到底是语言的model,还是智能的model,我怀疑是前者。

真正的人工智能,需要的input很少,一个小孩学到大学,读的书,跟人说的话,可能不到现在LLM训练材料的万分之一。人工智能的体现在于输入很少,输出很多,LLM是输入很多,输出很多。

如果你能意识到这个问题,那说明大多数在该领域的学者也早知道了。

#96 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 20:34

由 saibaster

Havana 写了: 2023年 12月 19日 20:32

chatgpt促成了prompt engineering就说明它是个笑话

这个确实是

#97 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 20:39

由 da1gaku

Havana 写了: 2023年 12月 19日 20:32

chatgpt促成了prompt engineering就说明它是个笑话

其实你跟真人讨论问题也是这样的。很多时候不是一问就准。

#99 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 21:01

由 Havana

普通程序给出了错误的结果会说这个程序有bug。在人工“智能”面前就变成了提问方式不对。

da1gaku 写了: 2023年 12月 19日 20:39

其实你跟真人讨论问题也是这样的。很多时候不是一问就准。

#101 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 21:10

由 Caravel

nohup 写了: 2023年 12月 19日 21:07

看一个系统具有什么样的智能,有很多测试的基准。其中很重要的一条就是归纳。

一个机器能归纳,毫无疑问,应该具有相当高的智能了。

你可以试试问问chatGPT: I have a sequence of numbers like 3, 5, 8, 13, 21, .... can you induct what this sequence is?

试试各种隐含规律的数列,看看chatGPT的回答 (直接给出通项公式),不得不承认这个语言模型是有智能的。起码很多人都未必能找到规律。

现在我写程序,经常会让chatGPT帮我写,给几个特殊情况,然后说其他类似情况都要能处理,chatGPT直接输出算法,把一般情况都解决了。它能从你说的特殊情况,总结出一般情况。比很多人聪明太多了。

天下程序一大抄,大概率ChatGPT见过类似的程序

#102 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 21:17

由 da1gaku

Havana 写了: 2023年 12月 19日 21:01

普通程序给出了错误的结果会说这个程序有bug。在人工“智能”面前就变成了提问方式不对。

不是不对

是对给定模型不是最佳

#103 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 21:20

由 Stk110

Caravel 写了: 2023年 12月 19日 14:14

大语言模型到底是语言的model,还是智能的model,我怀疑是前者。

真正的人工智能,需要的input很少,一个小孩学到大学,读的书,跟人说的话,可能不到现在LLM训练材料的万分之一。人工智能的体现在于输入很少,输出很多,LLM是输入很多,输出很多。

不明觉厉,似乎很有道理。

#104 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 21:39

由 shot

Caravel 写了: 2023年 12月 19日 14:14

大语言模型到底是语言的model,还是智能的model,我怀疑是前者。

真正的人工智能,需要的input很少,一个小孩学到大学,读的书,跟人说的话,可能不到现在LLM训练材料的万分之一。人工智能的体现在于输入很少,输出很多,LLM是输入很多,输出很多。

大语言模型已经比你聪明了,你还在这夸夸其谈。

你之所以觉得模型笨,是因为你笨,不会用。

就像一只猴子,你把爱因斯坦送给它用,它也用不好。

一把20公分的尺是量不出一米的深度的。

#105 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 21:45

由 shot

hahan 写了: 2023年 12月 19日 18:25

好吧

我曾经丢给一个doc 让chatgpt帮我proofread polish

结果有些句子的意思就变了

这个能用在法律文书吗

我把一个我的初稿扔给你润色,你能做到多好?

你能保证不改变我的意思吗?

你找一个专家来做这种事,至少两个星期,来回无数次扯皮。

人类自己做不到的事,却期待一个模型做到。

你想要的那个东西根本不是智能,而是超智能。

真搞出那种东西,你我都已经没有存在的必要了。

#106 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 21:46

由 Havana

左边的答案就是不对

da1gaku 写了: 2023年 12月 19日 21:17

不是不对

是对给定模型不是最佳

#107 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 21:51

由 shot

Havana 写了: 2023年 12月 19日 20:32

chatgpt促成了prompt engineering就说明它是个笑话

这是交流成本,正说明大语言模型是一种智能。

实际上,人和人之间的交流成本是极高的。

这是高级智能一个本质特征,每个人的神经网络参数都是不一样的。

这导致大家对相同事物的理解和猜测各不一样。

在大语言模型上,花的这点成本,跟人的交流成本比,小意思了。

#108 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 22:01

由 shot

Caravel 写了: 2023年 12月 19日 14:31

小孩和特别是成人的给出的回答是高度可靠的,而且通过纠错进一步提高。LLM没有纠错机制。

LLM很容易纠错,这叫精调模型。

每个人都可以调教出一个让他自己觉得舒心的模型,只要他有这个技能。

另外,人类给出的答案根本不是高度可靠的。

小部分人考试可以90分,大部分人考试只能60分。

一个可靠的人类专家,需要数十年的积累才能做到精确可靠。

这本质就是对人类神经网络进行精调,但是人类的神经网络没有延展性和传递性。

亿万人中指出了一个爱因斯坦,爱因斯坦死了也就没了。

这个成本如果用在精调和教育大语言模型上,效果会远好于人类。

每一个对口的模型训练出来,这个模型就会永远存在,就会直接淘汰掉人类的一个职业。

#109 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 22:10

由 Havana

这就是在用户端又加了一个统计概率优化。通过已知正确答案的问题来预测最佳提问方式,等这个黑盒子一升级,原来的客户端预测就失效。这和智能算是南辕北辙。

shot 写了: 2023年 12月 19日 21:51

这是交流成本,正说明大语言模型是一种智能。

实际上,人和人之间的交流成本是极高的。

这是高级智能一个本质特征,每个人的神经网络参数都是不一样的。

这导致大家对相同事物的理解和猜测各不一样。

在大语言模型上,花的这点成本,跟人的交流成本比,小意思了。

#110 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 22:11

由 da1gaku

Havana 写了: 2023年 12月 19日 22:10

这就是在用户端又加了一个统计概率优化。通过已知正确答案的问题来预测最佳提问方式,等这个黑盒子一升级,原来的客户端预测就失效。这和智能算是南辕北辙。

prompt engineering本来就是一种应用,是针对当前模型找到最好的使用方式。

随着模型升级,prompt需要的特技越来越少。

#111 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 22:14

由 Havana

对用户不知道正确答案的问题,用户不知道什么是正确的提问方式。

da1gaku 写了: 2023年 12月 19日 22:11

prompt engineering本来就是一种应用,是针对当前模型找到最好的使用方式。

随着模型升级,prompt需要的特技越来越少。

#112 Re: 大语言模型LLM大方向可能不对

发表于 : 2023年 12月 19日 22:15

由 laodongzhe18

大数据支持下的人云亦云,符合现代社会的知识处理机制。但是否有智能,譬如通过图灵测试,几乎无法证明。