1 DeepSeek(DS) 的算法

DS模型的加速主要有 3个算法技巧

1. Multi-head Latent Attention (MLA): MLA is designed to compress the Key-Value cache into a latent vector, significantly reducing memory usage during inference.

Key-Value降维压缩可减少内存使用 提高读取速度

压缩不是新技术 但用在这里是 DS 的首创

压缩缺点是会带来讯息损失

2. Mixture-of-Experts (MoE) Architecture: DeepSeek employs a sparse computation approach through its MoE architecture, enabling the model to activate only a subset of its parameters during processing. For instance, in DeepSeek-R1, while the total parameter count is 671 billion, only 37 billion parameters are activated per token.

MoE 的好处是每次只激活(计算)一小部分参数 (6%这里) 大大降低计算量

这是 DS 减少计算量最主要的地方

MoE 的 缺点是精度损失

且需要各种复杂的调制且结果很难稳定

毕竟每次只算了一小部分参数

MoE 是 Shazeer et al. 2017 首创 "Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer", published at Google Brain. Link: https://arxiv.org/abs/1701.06538

3. Used FP8 运算

8位浮点数 相对于 16 和 32 优点是比较快

FP8 缺点是截断误差大 结果不可靠

DS的一大创新算法是

Reinforcement Learning without Supervised Fine-Tuning: In developing DeepSeek-R1, they utilized reinforcement learning techniques without relying on supervised fine-tuning. This approach allows the model to improve its reasoning capabilities autonomously, reducing the need for extensive labeled datasets and associated training costs.

这个也是DS模型进步的核心因素

虽然 Reinforcement Learning不是新东西

Reinforcement Learning without Supervised Fine-Tuning 的实现算是 DS 独立研发

这个东西OpenAI-o1 也开发出来了并在使用 但没有开源公布

这个算是DS的新东西 但文章里语焉不详 没有透露细节 LOL

也没有公开模型训练代码 核心内容还是有所保留

以各大厂的人才济济 如果一个月内搞不定这个我会很鄙视他们 LOL

2 DeepSeek 拥有什么芯片

DeepSeek 属于幻方量化公司的产品

幻方量化 是中国一家对冲基金公司 从事量化股票交易

它不是一家小公司 曾管理基金1000亿 RMB

既做股票又做大模型 听上去是不是有点魔幻

手里有的是钱 在2021年 其手中就已经有了1万张 A100 GPU

Aug 26 2024, 他们的paper宣称拥有 10,000 块 A100 GPUs

在文章摘要里可以看到 https://arxiv.org/abs/2408.14158

Dec 27 2024, 他们的 DeepSeek-V3 paper claimed used H800 GPUs

See the abstract of the paper, Deepseek-V3: https://arxiv.org/html/2412.19437v1

最近 Alexandr Wang (born 1997, 身价 $2 billions ) , the founder and CEO of Scale AI, said DeepSeek actually has 50,000 H100s

See the video starts at 2:50

DeepSeek 到底拥有多少高级芯片确实是个谜

不过 用阉割版H800 训练模型几个月 而不用手里高级的A100

确实不是常人能够理解的

3 DeepSeek 开源吗

算是开了半个源

DeepSeek 训练好的权重 和推理源代码都开放了 大家可以使用

Inference model 在 https://github.com/deepseek-ai/DeepSeek-V3

但是他训练的源代码源程序并没有开放 也就是说你并不知道他到底是怎么练出来的

且重要部分在 report 里也语焉不详 https://arxiv.org/abs/2501.12948

( 备注一下 arxiv.org 是大家自己往上发文章的 不需要同行评审 )

有人想把源代码拿过来自己也练一个 想得太简单了

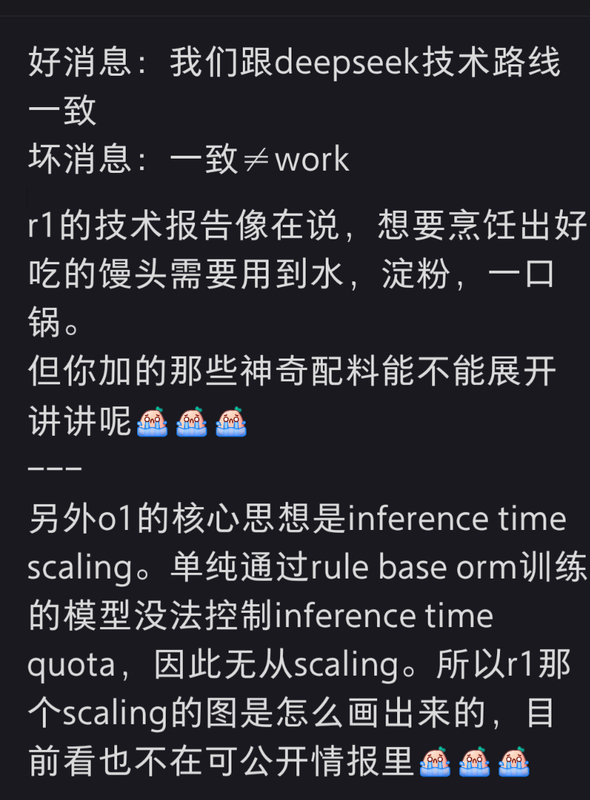

以上图片引自小红书 还有这个评论 “铁匠打造了一把锋利无比的斧子,斧子公开卖,你用起来也确实锋利无比(开源了模型权重),但是怎么锻造(训练)的确实含糊其辞”

4 DeepSeek 的花费

文章里说用了2080块 H800

每块H800 的价格是$ 30,603美元

2080 x $ 30,603 = $ 63,654,240

文章里说只花 $5M 这个花费实际是模型调好以后 最后一次训练成型的花费

做过研究的都知道 成功之前的无数次失败和调试运算

不知道是几百倍的 5M

有人觉得以后花个5百万也可以弄出个大模型 幼稚

5 总的来说

DS 的模型推动了行业的发展 是AI行业的一大喜事

其中 Reinforcement Learning without Supervised Fine-Tuning 是其独门进展

任何算法的改进都会促进行业的发展

使我们离AI又近了一步

DS的3个加速技巧则是是不得已而逼出来的 是牺牲精度换取速度

( 更感觉像给自行车装了个电瓶 让自行车跑得像汽车那么快 )

这些加速算法在模型开发初期是非常实用的 可以快速便宜地训练 迅速建立起一个差不多的模型

在落地上 则还有很长的路要走 最后还是要回到提高精度上来

觉得国内会想尽一切办法弄高级卡

比如这个神医常年蹲守2手版

viewtopic.php?t=197101

不会是只为了游戏玩家吧 LOL

一亿美元或许可以把模型训练到90%

十亿可以把模型训练到99%

百亿可以把模型训练到99.9%

千亿可以把模型训练到99.99%

要万亿可以把模型训练到99.999%

特斯拉的自动驾驶 觉得目标怎么也得 99.99%

===========================================================

Update:

上面说的加速算法都是次要的

关键的是DS 蒸馏了OpenAI-o1

所以模型训练收敛块 这属于作弊行为

怪不得在训练上含糊其辞

别人用同样的技术路线却做不出来

所以DS的真实成本应该是

OpenAI 的成本 + DS 的成本